Bạn có một “phòng lab tại gia” hay một ngôi nhà thông minh với Home Assistant đã được thiết lập? Có thể bạn đã kết nối nó với một trợ lý giọng nói cục bộ để điều khiển thiết bị mà không cần động tay, hay đã có nhiều hệ thống tự động hóa hoạt động. Nhưng sẽ thế nào nếu bạn có thể trò chuyện với trợ lý giọng nói đó một cách tự nhiên, giống như con người?

Việc sử dụng các loa thông minh từ những tên tuổi lớn trong lĩnh vực điều khiển giọng nói có thể tiện lợi, nhưng chúng lại không cho phép bạn kiểm soát dữ liệu của mình. Thay vào đó, bạn hoàn toàn có thể chạy một trợ lý giọng nói AI của riêng mình ngay tại nhà, không cần gửi dữ liệu về máy chủ bên ngoài, kết nối nó với Home Assistant và tạo ra một trợ lý AI với “tính cách” được tùy chỉnh riêng cho thiết lập nhà thông minh của bạn.

Bản thân tôi cũng đang chạy Ollama AI trên NAS của mình. Dù đây chưa phải là thiết lập tối ưu vì tôi không có GPU để tăng tốc độ tính toán, nhưng nó là minh chứng cho một ý tưởng tuyệt vời. Và giờ đây khi đã yêu thích nó, tôi dự định chuyển sang một máy chủ Proxmox chuyên dụng với GPU Nvidia để tận dụng CUDA cho khả năng suy luận AI hiệu quả hơn. Ít nhất, đây cũng là một ví dụ rõ ràng về những gì AI tác tử (agentic AI) có thể làm được trong tương lai, nếu các công ty ngừng theo đuổi chatbot văn bản và đầu tư vào loại giao diện người-máy mà mọi người hâm mộ Star Trek đã chờ đợi bấy lâu nay.

Giao diện Home Assistant với các tiện ích hỗ trợ, hiển thị khả năng tự động hóa nhà thông minh

Giao diện Home Assistant với các tiện ích hỗ trợ, hiển thị khả năng tự động hóa nhà thông minh

Yêu Cầu Cài Đặt: Home Assistant OS là Lựa Chọn Tối Ưu

Nhanh chóng và tiện lợi hơn so với container Docker

Mục tiêu chính khi bạn muốn liên kết Ollama (chạy các mô hình AI cục bộ) và Whisper (mô hình chuyển giọng nói thành văn bản) là để có một AI mà bạn có thể trò chuyện. Hơn cả việc chỉ nói chuyện, bạn có thể sử dụng nó để điều khiển Home Assistant và mọi thiết bị thông minh liên kết với dự án mã nguồn mở yêu thích của chúng ta. Để hoàn thiện cuộc trò chuyện giữa bạn và AI, bạn cần thêm một thành phần nữa là Piper, một mô hình chuyển văn bản thành giọng nói.

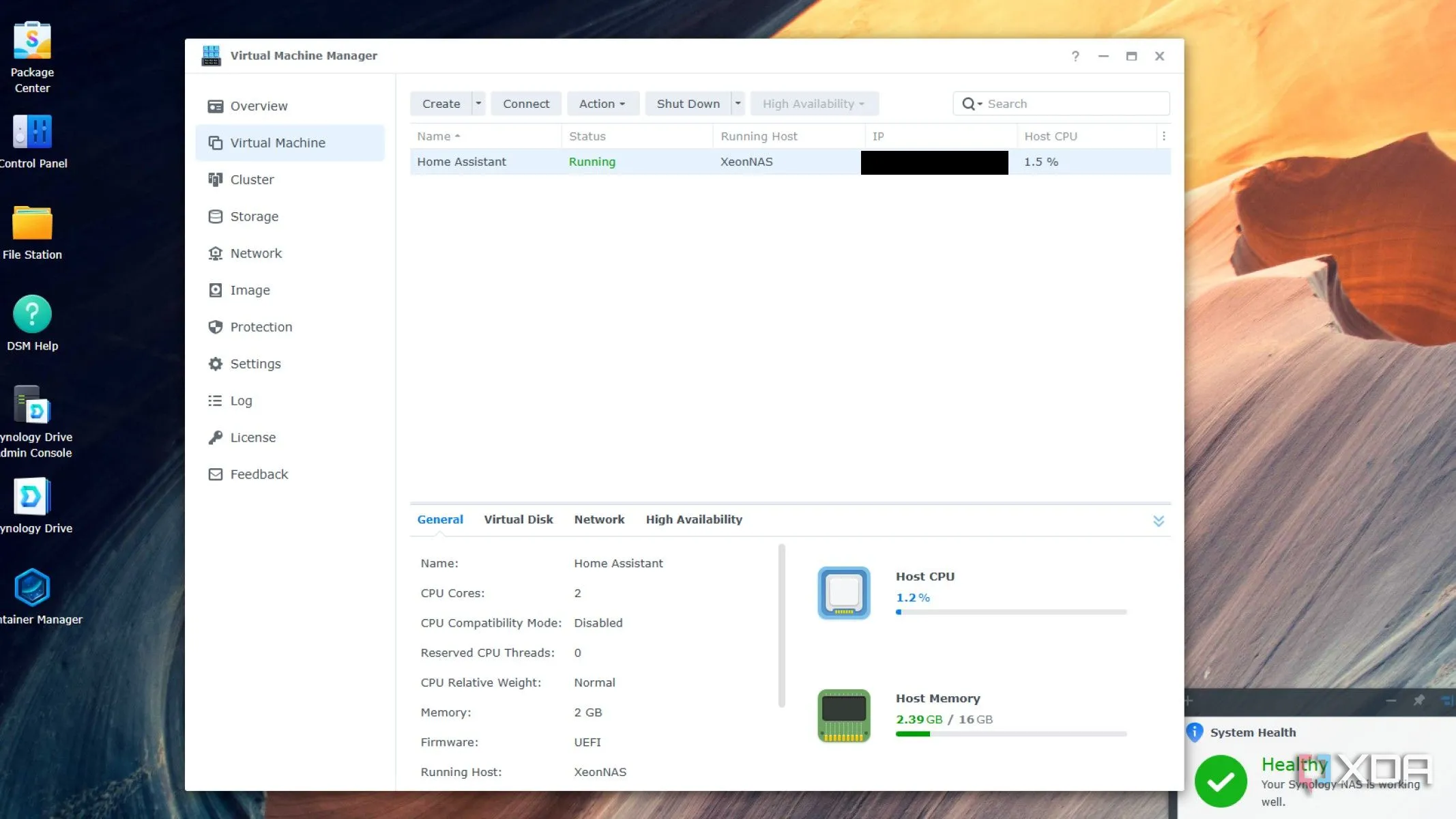

Việc thiết lập này đã đơn giản một cách đáng ngạc nhiên, đặc biệt đây là lần đầu tiên tôi sử dụng chatbot AI bên ngoài các phiên bản dựa trên web như ChatGPT. Tuy nhiên, có một điểm cần lưu ý. Ban đầu, tôi cài đặt Home Assistant dưới dạng Docker container trên NAS, và đó là cách làm khó khăn khi muốn thêm các dịch vụ khác. Thay vào đó, bạn nên cài đặt Home Assistant OS (HAOS) trực tiếp trên một Mini PC, hoặc dưới dạng máy ảo (virtual machine).

Màn hình quản lý máy ảo trên Synology DSM 7, minh họa Home Assistant OS đang chạy dưới dạng máy ảo

Màn hình quản lý máy ảo trên Synology DSM 7, minh họa Home Assistant OS đang chạy dưới dạng máy ảo

Lý do là cửa hàng add-on của HAOS không khả dụng trên phiên bản Docker, và nó giúp mọi thứ trở nên dễ dàng hơn rất nhiều. Nếu không, bạn sẽ phải tự thiết lập Whisper, Piper và Ollama trong các container Docker riêng biệt, sau đó liên kết chúng với Home Assistant, thay vì chỉ cần sử dụng cửa hàng add-on và có chúng như một phần của hệ điều hành.

Trang chủ ChatGPT, biểu tượng cho các mô hình AI dựa trên đám mây

Trang chủ ChatGPT, biểu tượng cho các mô hình AI dựa trên đám mây

Sức Mạnh Của Mô Hình AI Cục Bộ: Trải Nghiệm Cá Nhân Hóa Vượt Trội

Có một mô hình AI cục bộ là rất tiện lợi, nhưng có thể trò chuyện với nó còn tuyệt vời hơn

Phần tốn thời gian nhất của quá trình này là chờ đợi mô hình Llama 3 tải xuống. Việc tích hợp nó vào HAOS khá đơn giản, và việc đưa Whisper vào hoạt động cũng vậy. Tuy nhiên, nó phản hồi khá chậm, và chưa thể thay thế Alexa hay Google Assistant, ít nhất là ở thời điểm hiện tại. Nhưng chúng ta không còn xa nữa, và xét rằng những mô hình này từng yêu cầu phần cứng máy chủ đáng kể để chạy, việc chúng có thể hoạt động trên các thiết bị tiêu dùng đã là một điều khá ấn tượng.

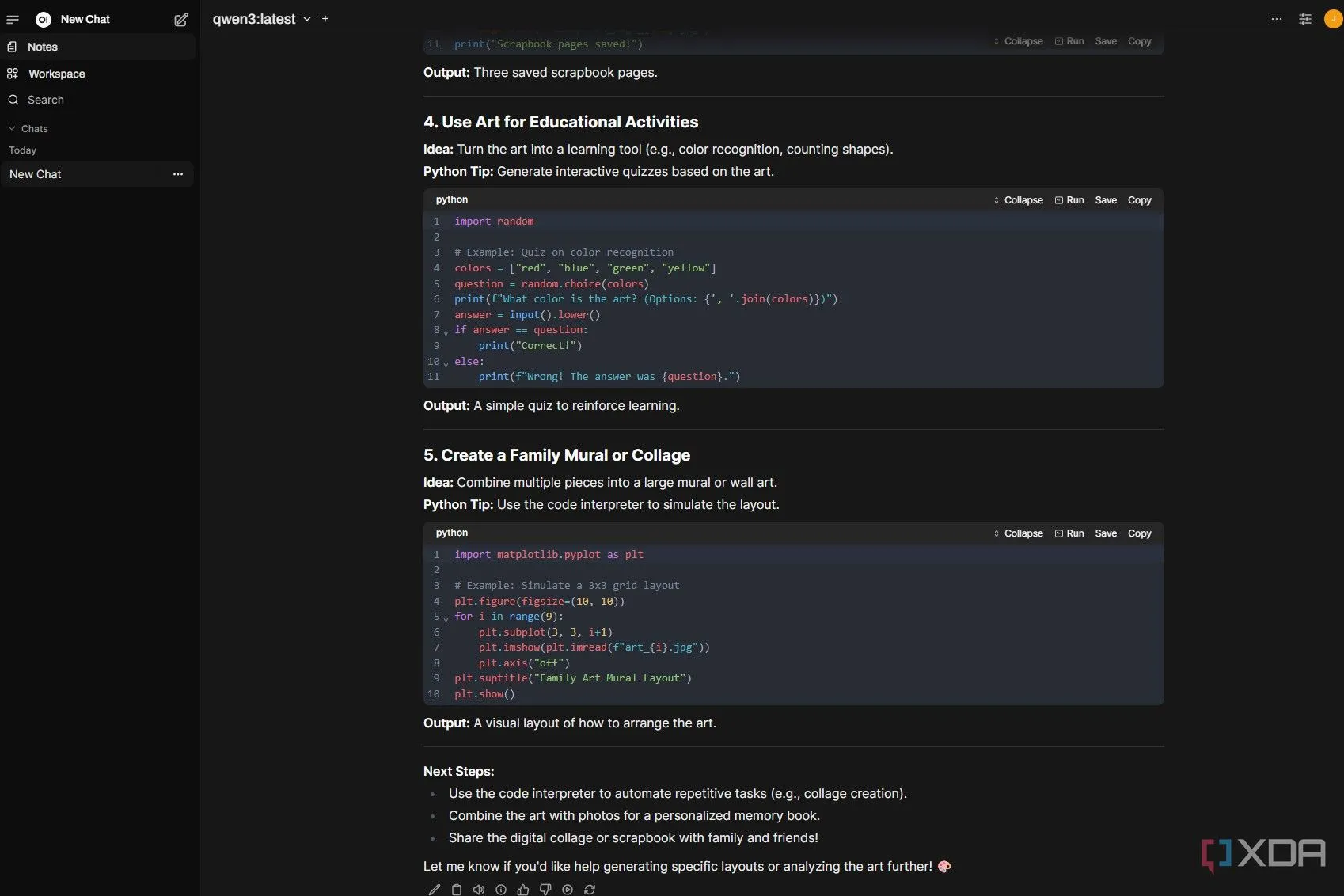

Tôi đã thiết lập Open UI để sử dụng Ollama qua văn bản cho mục đích thử nghiệm. Mặc dù nó mất một khoảng thời gian và khiến quạt NAS của tôi chạy ồn ào theo cách mà chưa có tác vụ nào khác làm được, nhưng cảm giác lạnh sống lưng vẫn xuất hiện khi biết rằng quá trình suy luận đang được thực hiện trên một thiết bị trong chính ngôi nhà của tôi, mà tôi sở hữu và tự thiết lập. Chắc chắn, người khác đã làm công việc khó khăn là đào tạo AI và phát triển các plugin để hoạt động với HAOS, nhưng đó vẫn là một thành tựu, giống như việc tự thay lốp xe của bạn.

Kết quả đầu ra của mô hình Qwen3 qua Ollama, hiển thị trong giao diện web Open UI trên hệ thống AI cục bộ

Kết quả đầu ra của mô hình Qwen3 qua Ollama, hiển thị trong giao diện web Open UI trên hệ thống AI cục bộ

Điều tuyệt vời là bạn có thể thay đổi cách AI phản hồi bằng cách đưa ra các lệnh văn bản cho nó. Add-on chuyển văn bản thành giọng nói không thực sự “thông minh”, nó đọc mọi thứ theo đúng nghĩa đen. Nhưng bằng cách nói cho Ollama biết điều đó, AI sẽ đưa ra văn bản tốt hơn để được chuyển đổi. Ví dụ, về thời gian, nếu 14:22 sẽ được đọc là “một-bốn-hai-hai”, thì bằng cách hướng dẫn AI điều chỉnh, nó sẽ thay đổi đầu ra thành “hai giờ hai mươi hai phút chiều” và cho bạn một phản hồi tốt hơn. Đó là một cái nhìn hấp dẫn về cách các hướng dẫn đàm thoại có thể lập trình AI một cách hiệu quả.

Mô hình Orca Mini LLM đang chạy trên Raspberry Pi 5 thông qua Ollama, minh họa khả năng AI cục bộ trên phần cứng nhỏ gọn

Mô hình Orca Mini LLM đang chạy trên Raspberry Pi 5 thông qua Ollama, minh họa khả năng AI cục bộ trên phần cứng nhỏ gọn

Nhà thông minh của tôi gần như thông minh hơn tôi

Dù không còn bị ràng buộc bởi Google hay Amazon cho trợ lý giọng nói, việc có trợ lý giọng nói cục bộ được cấp nguồn bởi Ollama của riêng tôi cũng mang lại niềm vui lớn. Bạn không cần phải chịu đựng sự cứng nhắc của các mô hình AI doanh nghiệp. Bạn có thể “huấn luyện” AI của mình trở nên “thô lỗ” hoặc “châm biếm”, hoặc yêu cầu nó giới hạn lượng thông tin vô ích khi bạn yêu cầu tắt đèn. Điều đó khiến nó thực sự là của riêng bạn, và sự kiên trì trong việc tìm hiểu cách chạy mô hình và kết nối mọi thứ đã hoàn toàn xứng đáng.